Ентусиасти успяха да пуснат един от популярните днес модели с изкуствен интелект на древен компютър с процесор Pentium II и операционна система Windows 98. Системата е способна да генерира текст с относително висока скорост.

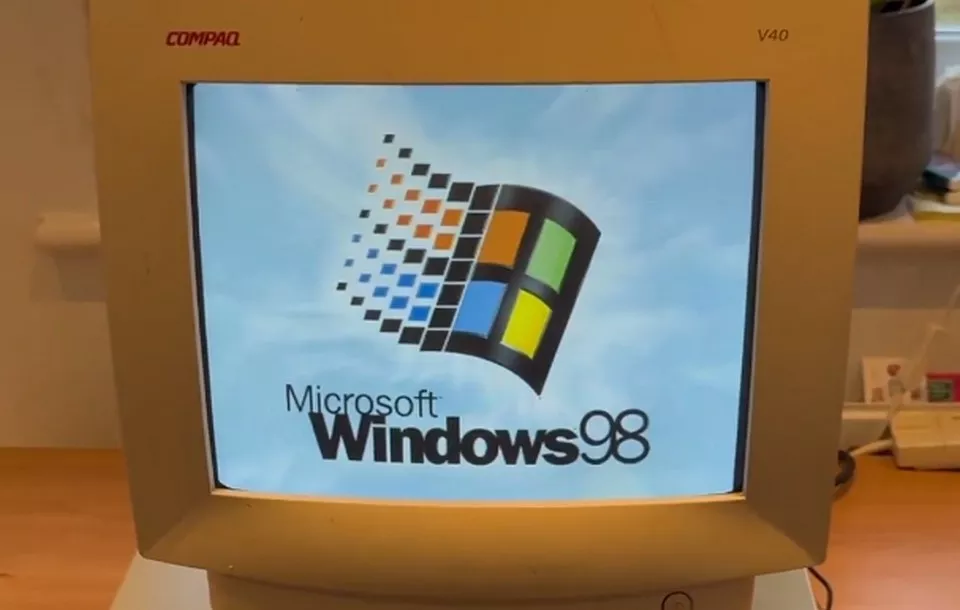

Експертите от EXO Labs адаптираха мощния голям езиков модел (LLM) Llama, разработен от Meta, на 26-годишен компютър с операционна система Windows 98. Те показаха нагледно как стар компютър, оборудван с процесор Intel Pentium II с тактова честота 350 MHz и 128 MB RAM, може да стартира и взаимодейства с невронната мрежа.

За да пуснат LLM на древния PC, специалистите на EXO Labs са използвали собствен изходен интерфейс за алгоритъма Llama98.c, който е създаден въз основа на енджина Llama2.c, написан на езика за програмиране C от Андрей Карпати, бивш служител на OpenAI и Tesla, съобщи Tom’s Hardware.

След зареждане на алгоритъма, компютърът е помолен да създаде история за Сънливия Джо. Изненадващо, AI моделът е проработил на стария РС и е съчинил историята със сравнително добра скорост.

Мистериозната организация EXO Labs, създадена от изследователи и инженери от Оксфордския университет, се появи на сцената през септември тази година. Тя се застъпва за отвореността и достъпността на технологиите, базирани на изкуствен интелект.

Представители на организацията смятат, че напредналите AI технологии не трябва да бъдат в ръцете на шепа корпорации, както е сега. В бъдеще те се надяват да „изградят отворена инфраструктура за обучение на усъвършенствани AI модели, позволявайки на всеки да ги управлява навсякъде”.

Демонстрацията с LLM на древен компютър (видео в X), според изследователите, доказва, че алгоритмите за изкуствен интелект могат да работят на почти всяко устройство.

В своя блог ентусиастите разказват, че са закупили стар компютър с Windows 98 от eBay. След това го свързали към мрежата с помощта на Ethernet конектор и прехвърлили необходимите данни в паметта чрез FTP. Компилирането на кода за Windows 98 се оказва по-трудна задача, която е решена от Андрей Карпати и публикувана в GitHub.

В крайна сметка ентусиастите постигат скорост на генериране на текст от 35,9 токена в секунда, използвайки 260K LLM с архитектура Llama, което е доста добро постижение, предвид скромните изчислителни възможности на компютъра.

1 коментар

Не виждам какво впечатляващо намирате в това. Големите езикови модели са доста прости алгоритми на базата на transformers. Умножения на големи матрици. А тези, които са с по-малък брой параметри (0.5 милиарда например) работят без никакъв проблем на стандартен процесор, без да имат нужда от видео карта.