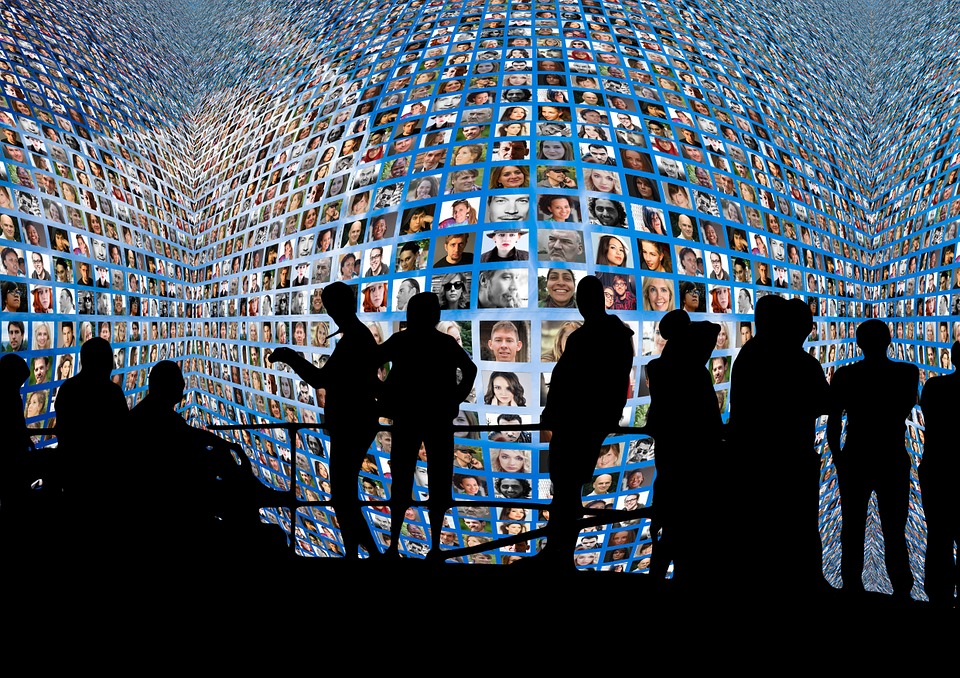

Изкуствен интелект контролира до голяма част това какво съдържание гледаме онлайн. В социалната мрежа за видео YouTube безбройните потребители прекарват общо 700 000 000 часа всеки ден в гледане на клипове, препоръчани от платформата. По същия начин механизмът за препоръки във Facebook кара хората да стоят в социалната мрежа 950 000 000 часа на ден. Ала този механизъм за препоръки е много опасен, предупреждава един от неговите създатели.

През февруари потребител на YouTube установи, че алгоритъмът за препоръки улеснява педофилите да се свързват помежду си и да споделят детско порно в секциите с коментари на определени видеоклипове. Откритието бе ужасяващо по много причини. YouTube е заинтересован от повече гледания, заради бизнес модела си, но алгоритъмът за препоръки активно тласка хиляди потребители към намирането на още повече нередно съдържание.

Когато новината гръмна, Дисни и Нестле изтеглиха рекламите си от платформата. YouTube премахна хиляди видеоклипове и блокира възможностите за коментиране на много други. За съжаление това не е нито първият подобен скандал, случил се с YouTube през последните години, нито ще е последният. Алгоритъмът за препоръки може да популяризира терористично съдържание, екстремна омраза, зоофилия, педофилия и др.

„След като съм работил по системата за препоръки на компанията, бих могъл да предскажа, че нейният ИИ умишлено ще популяризира вредните клипове, довели до всеки един от тези скандали”, казва пред Wired Гийом Часлот, специалист по изкуствен интелект, който е работил точно върху алгоритъма за препоръките на YouTube в периода 2010 – 2011 г.

„Това е алгоритъмът, който определя какво видео ще ви се предлага, въз основа на предишните ви навици и търсения. Една от основните ми задачи в YouTube беше да увелича времето, което хората прекарват в YouTube. По това време целта изглеждаше безобидно. Но почти десетилетие по-късно виждам, че работата ни е имала непреднамерени, но не и непредвидими последствия. В някои случаи изкуственият интелект отиде в твъде грешна посока”.

Бедствие с изкуствения интелект

Използвайки алгоритъм за препоръки, изкуственият интелект на YouTube цели да увеличи времето, което хората прекарват онлайн. Тези алгоритми проследяват и измерват предишните навици на гледане на потребителя – например какво е гледал, по колко време, каква част от всеки клип е била гледана или прескочена и т.н. Проследява и други подобни потребители – за да намери и препоръча други видеоклипове, които биха ангажирали човека.

В случая с педофилския скандал, ИИ на YouTube активно е препоръчвал на потребителите, за които е най-вероятно да се ангажират с подобни видеоклипове, записи с участието на деца. Колкото по-силен става ИИ – тоест, колкото повече данни събира – толкова по-ефикасно става умението му да препоръчва конкретно съдържание за конкретен потребител.

И ето тук ИИ става опасен, според Часлот. Докато ИИ се усъвършенства, той става все по-точен в това да предвиди кой точно се интересува от дадено съдържание; става все по-малко вероятно той да препоръча въпросното съдържание на потребители, които не са склонни да се ангажират с подобно видео. На този етап проблемът става много труден за забелязване, тъй като е малко вероятно съдържанието да бъде докладвано. Така порочната верига може да продължи години наред.

Но този сценарий е само пример за по-голям проблем.

Порочен кръг

По-рано тази година изследователите от Google Deep Mind проучваха въздействието на препоръчващите системи – като тези, използвани от YouTube и други подобни платформи. Те заключиха, че „веригите за обратна връзка при препоръчващите системи може да доведе до „ехо-камери” и „филтърни балони”: тези алгоритми могат да ограничат достъпа на потребителя до съдържание и по този начин в крайна сметка да променят неговия мироглед.

В реалния свят ИИ, създателите на съдържание и потребителите силно си влияят един на друг. Тъй като ИИ има за цел да максимизира ангажираността, то хипер-ангажираните потребители се възприемат като „модели, които трябва да бъдат възпроизвеждани”. Алгоритмите за ИИ благоприятстват съдържанието от такива потребители.

Цикълът за обратна връзка работи по следния начин:

1. Хората, които прекарват повече време в платформите, имат по-голямо въздействие върху препоръчващите системи;

2. Съдържанието, с което те се ангажират, получава повече мнения/харесвания;

3. Създателите на съдържание забелязват и създават повече съдържание от този вид;

4. Хората прекарват повече време в гледане на този вид съдържание.

Ето защо е важно да се знае кои са свръх-ангажираните потребители на дадена платформа от типа на YouTube: ако се вгледаме в тях, можем да предвидим в коя посока ИИ ще накланя света.

В по-общ план е важно да се проучи структурата на стимулите в основата на механизма за препоръчване. Компаниите, които използват алгоритми за препоръки, искат потребителите да се ангажират с техните платформи колкото се може по-често и по-дълго, защото такъв е техният бизнес-интерес. Понякога е в интерес и на потребителя да остане в платформата колкото е възможно по-дълго – например при слушане на хубава музика – но не винаги.

Знаем, че вредното съдържание води до значителна ангажираност. Дори ако потребителят забележи нередност във видеото и го маркира, това се случва след като той вече го е гледал, т.е. ангажирал се е с него. Вече е твърде късно: подаден е положителен сигнал на алгоритъма. Сега, когато това съдържание е било интересно някому по някакъв начин, то бива подкрепено, което пък кара създателите на подобно съдържание да качват повече от него.

Задвижвани от алгоритмите на изкуствения интелект, стимулирани да насърчават видеата, които провокират повече ангажираност, филтрите за съдържание в системите за препоръки усилват порочния кръг. На всичкото отгоре веднага щом ИИ научи как е успял да ангажира един човек, той може да възпроизведе същия механизъм върху хиляди други потребители.

[related-posts]

Дори и най-добрият ИИ в света може активно да насърчава нередно и вредно съдържание, преследвайки потребителска ангажираност. Потребителите трябва да разберат основата на изкуствения интелект и да гледат внимателно на системите за препоръки.

Отговорността, разбира се, не може да пада единствено върху потребителите. Факт е, че през изминалата година компаниите стават все по-активни в тази промяна.

Но ако искаме да избегнем бъдеще, изпълнено с дезинформация и вредно съдържание, трябва да свършим много повече работа. Потребителите трябва да разберат кои ИИ алгоритми работят за тях и кои работят срещу тях.

1 коментар

В САЩ зоофилията не е забранена във всички щати, а централно съвсем не е. Как трябва да се третират тогава материалите на такава тематика? В България е забранено “сексуално малтретиране на животни”, което както и да го четем не е пълна забрана на зоофилията.